신경망기반 소형 생성언어모델(SLM)은 방대한 텍스트 데이터를 학습해 자연어를 이해하고 생성할 수 있는 인공지능(AI) 모델로, 주어진 입력에 가장 자연스럽게 이어지는 말을 생성할 수 있다.

한국전자통신연구원(ETRI)이 한국어 중심 신경망기반 소형 생성언어모델(SLM)을 개발해 오픈소스로 일반에 공개했다. 이에 따라 기존 대형언어모델을 활용할 수 없었던 중소·중견기업에게 큰 도움이 될 전망이다.

3B급 SML 오픈소스 공개

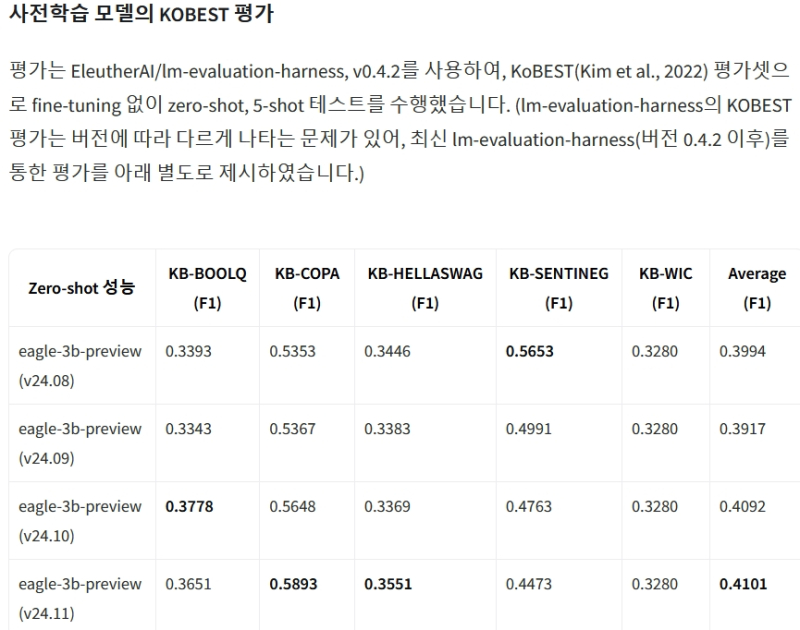

ETRI는 3B(30억 개 파라미터)급 신경망 기반 SLM ‘이글(Eagle)’을 개발해 허깅페이스 허브에 공개했다고 28일 밝혔다.

3B급은 신경망 모델이 학습과정에서 조정할 수 있는 수치화된 값들이 30억 개 존재한다는 의미로, 파라미터의 수가 많을수록 모델의 복잡성이 커지고 그만큼 뛰어난 학습능력을 기대할 수 있다.

생성형언어모델은 방대한 텍스트 데이터에서 인간 언어능력을 학습해 목적에 맞게 사용자 질문이나 지시에 따라 자연스러운 대화나 텍스트 콘텐츠를 만들어낸다.

생성형 언어모델을 선도하는 글로벌 빅테크기업은 과거 100억~1000억 파라미터의 중대형 모델 개발에 집중하다가 최근 10억~40억 파라미터 규모 소형 개방형 모델을 공개하고 있다.

마이크로소프트의 ‘파이(Phi)’, 구글의 ‘젬마(Gemma)’, 메타의 ‘라마 3.2(LLaMA 3.2’ 등이 이에 해당한다.

그러나 이들 모델은 한국어 어휘를 음절이나 바이트 단위로 처리하기 때문에 동일한 문장을 표현하는 데 더 많은 연산을 필요로 한다.

게다가 학습한 데이터 중 한국어 데이터가 전체의 5%에도 못 미치는 못해 우리말 이해와 생성능력이 영어보다 상대적으로 낮다.

ETRI가 개발한 이글은 한국어 데이터 비중이 훨씬 높은 것이 특징이다. 이를 통해 연산 횟수를 줄이면서도 효율적인 학습과 추론이 가능하다.

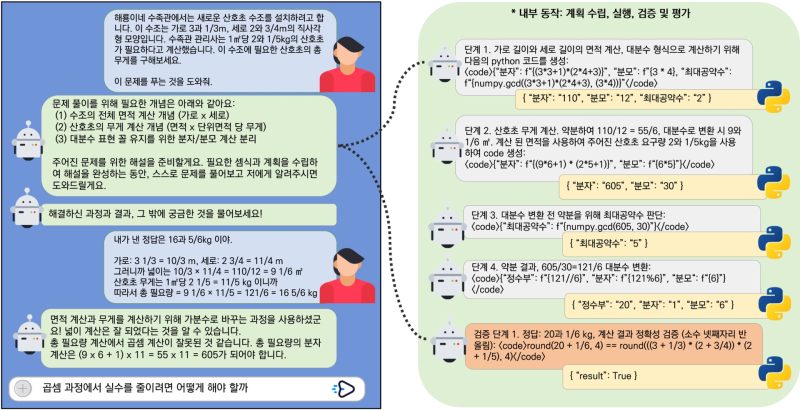

실제 한국어 숫자 연산을 수행하는 미세조정 실험에서 ETRI의 13억 파라미터 모델이 글로벌기업 모델의 절반 규모임에도 특정 작업에서 15% 더 높은 성능을 기록하기도 했다.

또 국내 기업이 공개한 기존 한국어중심 언어모델이 질의응답 과업에 맞춰 조정된 기정렬 모델이라는 한계에 비해 ETRI 모델은 미세조정이 적용되지 않은 기초 모델로 제공한다.

기초 모델은 기정렬 모델에 비해 새로운 목적의 과업에 추가 학습을 적용할 경우 응용모델의 기대 성능이 더 높고, 학습시간도 20% 가량 단축되는 등 보다 우수한 성능을 발휘할 수 있다.

중소·중견기업 연구개발 지원 기대

ETRI 연구진은 이글이 생성형 AI 응용개발 과정에서 연산 비용 부담을 느끼는 중소·중견기업에 적합할 것으로 기대하고 있다.

게다가 기초모델에 특화된 용도를 반영해 추가 학습을 수행함으로써 기업 자체의 맞춤형 기초모델을 제작할 수 있는 연장 학습도 용이하다.

아울러 ETRI는 해외 빅테크기업의 기초모델보다 투입할 수 있는 컴퓨팅 자원이 적은 한계를 극복하기 위해 신경망 기초모델이 개념 표현을 효과적으로 습득할 수 있도록 하는 추가 연구를 진행 중이다.

이와 함께 기초모델의 표현 품질을 예측할 수 있는 기술과 개념단위로 조합해 추론하는 원천기술도 함께 개발 중이다.

또 ETRI는 70억 파라미터 모델과 사전 정렬로 추가 학습 없이 사용자 요청에 응답하는 모델을 내년까지 순차 공개할 계획이다.

권오욱 ETRI 언어지능연구실장은“현재 공개한 언어모델이 풍부한 자원을 기반으로 개발되지 않아 모든 면에서 해외 우수 모델들보다 나을 수는 없지만 상대적으로 작은 한국어 토종모델이 필요한 산학연 여러 분야 연구개발에 큰 도움이 될 것”이라고 말했다.

한편, 이번 연구는 과학기술정보통신부와 정보통신기획평가원(IITP) 지원 ‘사람처럼 개념적으로 이해 추론이 가능한 복합인공지능 원천기술 연구’로 진행됐다.